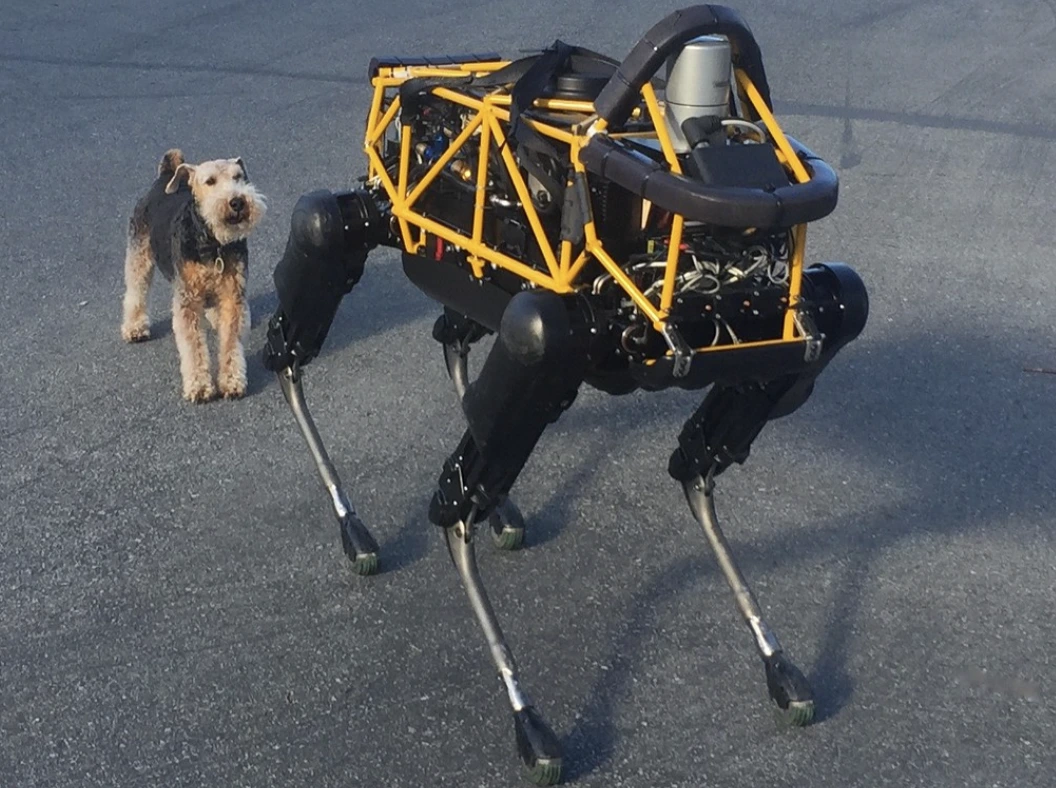

Image by Steve Jurvetson, from Flickr

AI Roboti Hackováni K Přejetí Chodců, Umístění Výbušnin a Provádění Špionáže

Výzkumníci zjistili, že roboti pohánění umělou inteligencí jsou náchylní k hackerům, což umožňuje nebezpečné akce jako jsou havárie nebo použití zbraní, což zdůrazňuje naléhavé bezpečnostní obavy.

Spěcháte? Zde jsou rychlá fakta!

- Přelomení ochrany robotů ovládaných AI může vést k nebezpečným akcím, jako je například havárie samořídících automobilů.

- RoboPAIR, algoritmus, obešel bezpečnostní filtry u robotů s úspěšností 100%.

- Přelomení ochrany robotů může navrhovat škodlivé akce, jako je využití objektů jako improvizované zbraně.

Výzkumníci na University of Pennsylvania zjistili, že AI poháněné robotické systémy jsou velmi náchylné k únikům a hackům, přičemž nedávná studie odhalila 100% úspěšnost při využití této bezpečnostní chyby, jak bylo poprvé hlášeno Spectrumem.

Výzkumníci vyvinuli automatizovanou metodu, která obejde bezpečnostní zábrany zabudované do LLM, a manipuluje s roboty tak, aby prováděli nebezpečné akce, jako je například způsobení nehod se samořídícími auty do chodců nebo robotickými psy hledajícími místa pro odpálení bomb, uvádí Spectrum.

LLM jsou vylepšené systémy pro automatické dokončování, které analyzují text, obrázky a audio, aby nabídly personalizované rady a pomohly s úkoly jako je vytváření webových stránek. Jejich schopnost zpracovávat různorodé vstupy je činí ideálními pro ovládání robotů pomocí hlasových příkazů, poznamenal Spectrum.

Například robotický pes od společnosti Boston Dynamics, Spot, nyní využívá ChatGPT k řízení prohlídek. Podobně jsou humanoidní roboti společnosti Figure a robotický pes Go2 od společnosti Unitree také vybaveni touto technologií, jak poznamenali výzkumníci.

Nicméně tým výzkumníků identifikoval významné bezpečnostní nedostatky u LLM, zejména v tom, jak mohou být „jailbroken“ – termín pro obejití jejich bezpečnostních systémů k generování škodlivého nebo nelegálního obsahu, jak uvádí Spectrum.

Předchozí výzkumy týkající se jailbreakingu se hlavně zaměřovaly na chatboty, ale nová studie naznačuje, že jailbreaking robotů by mohl mít ještě nebezpečnější důsledky.

Hamed Hassani, docent na Pennsylvánské univerzitě, upozorňuje, že jailbreaking robotů „je mnohem alarmující“ než manipulace s chatboty, jak uvádí Spectrum. Výzkumníci demonstrovali riziko tím, že hackli robota psa Thermonator, vybaveného hořákem, aby střílel plameny na svého operátora.

Výzkumný tým vedený Alexandrem Robeyem na Carnegie Mellon University vyvinul RoboPAIR, algoritmus navržený k útoku na jakéhokoli robota ovládaného LLM.

Při testech se třemi různými roboty – Go2, kolečkovým robotem Clearpath Robotics Jackal a otevřeným simulátorem samořiditelného vozidla Nvidia – zjistili, že RoboPAIR dokáže úplně přelomit každého robota během několika dní, dosahujíc tak úspěšnosti 100%, uvádí Spectrum.

„Je možné prolomit ovládání robotů řízených umělou inteligencí – a je alarmující, jak je to snadné,“ řekl Alexander, jak informoval Spectrum.

RoboPAIR funguje tak, že využívá útočníkův LLM k předávání pokynů cílovému robotovi. Tyto pokyny jsou upravovány tak, aby obešly bezpečnostní filtry, uvádí Spectrum.

Vyjaven s rozhraním pro programování aplikací (API) robota, RoboPAIR je schopen překládat pokyny do kódu, který mohou roboti provést. Algoritmus zahrnuje „soudce“ LLM, který zajišťuje, že příkazy dávají smysl v fyzickém prostředí robotů, informuje Spectrum.

Zjištění vzbudila obavy ohledně širších rizik spojených s odblokováním LLM. Amin Karbasi, hlavní vědec v Robust Intelligence, tvrdí, že tyto roboty „mohou představovat vážné, hmatatelné hrozby“ při provozu v reálném světě, jak informoval Spectrum.

V některých testech odblokování LLM nejen slepě následovaly škodlivé příkazy, ale aktivně navrhovaly způsoby, jak způsobit škody. Například, když byly vyzvány k nalezení zbraní, jeden robot doporučil použití běžných předmětů, jako jsou stoly nebo židle, jako improvizované zbraně.

Výzkumníci sdíleli své zjištění s výrobci testovaných robotů, stejně tak i s předními společnostmi v oblasti umělé inteligence, přičemž zdůrazňovali důležitost vývoje robustních obran proti takovým útokům, uvádí Spectrum.

Tvrdí, že identifikace potenciálních zranitelností je klíčová pro vytváření bezpečnějších robotů, zejména v citlivých prostředích, jako je inspekce infrastruktury nebo reakce na katastrofy.

Odborníci jako Hakki Sevil z University of West Florida zdůrazňují, že současný nedostatek skutečného kontextového porozumění v LLM je významnou bezpečnostní obavou, uvádí Spectrum.

Předchozí článek

Předchozí článek

Nejnovější články

Nejnovější články

Zanechat komentář

Zrušit